旬は過ぎたけど京大のips細胞研究所の研究不正が話題になっていた。 サプリメンタリーを含めて論文のほぼ全ての図表が対象ということ。 なので残念だが意図的な改竄なのだろう。

表に出てこない研究不正というのもあるだろう。 しかしこういった生命科学の分野は成果や雑誌が派手になりやすいもの。 インパクトが大きい反面比較的バレやすい分野なのかもしれない。 それだけ期待をされている分野ともいえよう。

私のいる分野は正式だろうが不正だろうがあまり注目されない分野なのだが、この機会にせっかくなのでちょっと研究不正について考えてみることにした。

研究不正が起こるのはなぜか?

金

最近あまり見ないけれど、きっとこういう改竄もあるのだろうね。 資金出すから都合の良いデータ出しといて的な。

網羅しているかは知らないが、発覚した研究不正の一覧についてはwikiでみることができる[1]。

研究者は研究資金の提供先から影響されちゃいけないのだ。

研究者の不安定な将来

最近はむしろこっちが多いのではないだろうか。 やっぱりなんだかんだで研究者の不安定身分ってのは大きいよ。 特に日本では。

某東大の教授がおっしゃっていたけれど、日本ではある年齢域を超えるとそれに合わないポジションが取れなくなる。 だからなんでも良いからさっさとポジション取れと。

そういうシステムを変えることのできる立場の人が、学生をそっち方向に後押ししてるんだからシステムが変わることは当分ないはず。

現状そういう状態なのだからポスドクや任期付助教は、できるだけ早くにやめたいというポジション。 それではじっくりと腰を落ち着けて研究に邁進することも難しい。

年が行ってようが行ってまいが能力のある人がふさわしいポジションを取れる制度ならば焦ることもない。 むしろしっかりとポスドクや任期職中に技術・知識・人脈を広げることに集中できるだろう。 逆に実力に合わないポジションを早々に掴んでしまうのもなかなかにして不幸なことだろうしね。

私もポスドク期間がだいぶ長いが、次のステップに進んでも大丈夫かなと思えたのはつい最近だ。 私はいろいろと他の問題も抱えているから、実際に次のステップに進めるかどうかはわからないがそこは今は問題じゃない。

数年前に運だけで次のステップに進んでいたら、きっとうまくいかなかっただろうなと思うのだ。

それからドロップアウトした研究者の受け皿ってのもはっきりしていない。 というかあるのかな? 例えば企業が研究職のような特化した人たちを中途で上手に採用するのにはそれなりに経験とノウハウが入りそう。 ヨーロッパ・アメリカは少なくとも求人は見るけれど、日本はどうなのだろう。

もちろんボスのコネとかで企業に行く人もいるし、自力で何かしら見つけて転職する人もいる。 とはいえどこに行ったかわからない人もいるのだからもったいない。

なんだかんだでphdまでとる才能か努力を見せた研究者。 そんな人材をうまいこと再利用できる仕組みってのがあっても良いのじゃないかとも思う。

わかりやすい逃げ先があれば不正してまで待遇の良いわけでもないアカデミックな研究職に執着することもないだろう。

だいぶ脱線したので話を戻す。 そんな不安定な状況下で一発当たれば大きい研究テーマをやっていたとする。 後1・2個良いデータがあるだけでハイインパクトな雑誌に投稿できるってなったら、何かしら悪魔が耳元で囁いちゃう人もいるんじゃないか。 特に職が期限切れ間近だったらね。

技術的容易性

実験研究者の場合研究不正は技術的には難しくない。 理論研究の研究不正ってあったのかしら?

実験の場合数値の改竄なんて追試をしなきゃ分からないだろう。 近年だと得られた図を適当に捏造するなんてのも別に難しいことではない。 そういった画像改変スキルなどは別の職種ではむしろ求められるものなんじゃないだろうか。

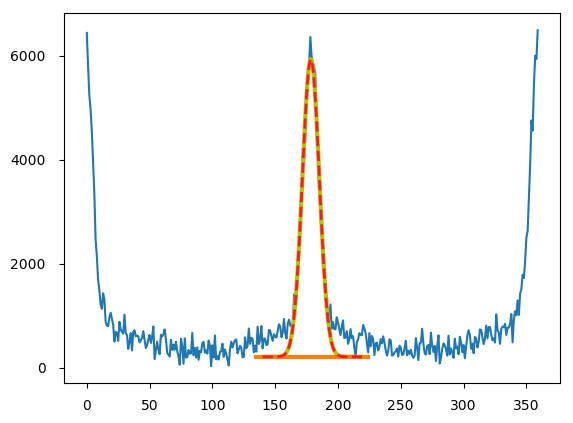

そもそも論文を書くときに生データをそのまま載せることはまずない。 生データってとってもわかりにくいから。 そんな生データを綺麗にみせるために色々と工夫する必要がある。

そんなデータプロセスはデータを綺麗に見せつつも、科学的本質を変えないようにというところに苦労するものなのだ。 これには理論的な補正、偶発的機械的エラーの修正、バックグラウンド除去、スムージングなどの操作が含まれる。

しかしあまりにこういったデータプロセスに慣れすぎると、思わず手が滑ってデータを綺麗にしすぎた! なんて不正もあるのでしょうかね。

内部発覚の可能性も低い

一番気がつく可能性が高いのは直接の研究の上司だろう。 しかし同じ目標を目指して苦労してデータを集めていて、ちょっと都合のいいデータが出てきたとする。 それを疑うことのできる研究者というのはあまりいないかもしれない。

というかいちいちデータの捏造を疑ってくるボスとか嫌だし。 解析ミスを疑う人はかなりいるので、その過程でふと改竄を見つけるなんてことはあるのかな。

シニアオーサーが直近のボスじゃない場合はそこでも発覚のチャンスありか。 シニアオーサーは結構しっかり読む人が多いと思う。

ここでもやはり捏造を疑うってよりは、何かおかしいから追試したらってくらいで言われるのだろうけど。

それ以外の著者が気づくかというと微妙だと思う。 今回の論文も10人も著者がいるらしいけど、逆にしっかり読んでる人が少ないって可能性もある。

自分の実験と結果考察が絡んでいない場所までがっつりと読み込んでくれる。 そんな時間のある素敵な共同研究者って残念ながらあまりいない。 たまにいると逆に面倒臭かったりもするけれど。

雑誌の査読を通り抜けちゃう可能性も結構ある

さていよいよ論文をどっかの雑誌に投稿するとする。 科学論文は最初に雑誌のエディターが読む。 論文が新規性があってその雑誌にふさわしいかどうかを判断するのだ。

ここが通常の論文を通す時には意外と難しいところなんだ。 しかしエディターはよっぽどあからさまでなければ研究不正かどうかなんて考えもしないだろう。

あからさまならその前段階ではじかれているだろうし。 というわけで改竄されたような派手論文はむしろ通り抜ける可能性が高い。

エディターの審査を通り抜けるといよいよ同じ分野で学ぶ研究者の査読(論文が正しい方法でデータをとって、正しく解釈しているかのチェック)へと回ることになる。

査読に当たる研究者は著者からも推薦できる雑誌が多い。 それから査読をしてほしくない研究者を数人選ぶこともできる(とても同じ分野を競っている同業研究者など)。

大概は推薦から一人か二人、雑誌独自に選んで一人か二人といった感じで査読者が選ばれるだろう。

さて。 分野しだいだろうけど完全に同じことをやっていて、かつ公正に評価してくれる研究者ってのはなかなかいない。

そうすると同じテーマをやってるけれど解析手法は違う人。 同じ解析手法だけどちょっと違うタイプのサンプルを使ってる人。 そんな人たちへと査読が回ることになる。

そうなると査読が回ってきた研究者は、自分の専門でわかるところを中心に読むことになる。 そのため自分の専門以外の部分へのチェックは甘くなることもあるだろう。

私自身が査読した経験でも似たような事例がある。 かなり考察の甘い論文だったので、かなりきつめの修正を要求したことがあったのだ。 だがその時のもう一人の査読者は4行くらいの短文。 しかも問題なしの良い論文だとのことで終わっていた。

翻って自分が論文を投稿する場合でもだいたいそんな感じだ。 一人か二人は真面目に読みこんでくれることが多いけど、読んだか読んでないかわからないような返答が混ざっていることもあるものだ。

それから査読をするにしても査読者は研究不正を前提に論文を読んだりはしない。 なのでむしろデータが綺麗な不正論文は、ここをあっさり通り抜けてしまう可能性が高いとすら言える。

真面目に追試する時間のある人があまりいない

さて一旦査読者の審査を通り抜けると、論文が出版されることになる。 ここまできたら発覚の最後のチャンスだ。

少しでも興味を持たれる内容の論文だった場合、どこかしらのグループが再試や実験手法を応用しようとするかもしれない。 今回のケースはこの例だろうか?

なので興味を持たれない不正論文は単に埋もれていくんじゃないだろうか。

ちょうど私も今ある論文の実験の追試をボスに頼まれてやっている。 これがなかなかにして面倒臭い。 適当に書いてあることも多い実験手法を、一つ一つと再現していかないといけないからだ。

完全に実験をコピーできたと思っても何かしらその論文の手法と異なるところがあるかもしれない。

というわけでぱっと追試して同じ結果が出なかったとしても、研究不正という言葉は浮かばない。 手法の細かい条件設定や何かしら書き洩らされた描写があるんじゃないかなど、チェックすることがたくさんあるからだ。

何度か追試をして同じ結果が出ない場合、いよいよ論文の著者に連絡することになるだろう。 論文を投稿すると一人か二人連絡担当の著者を決めているはずだ。 論文を読んでも不明なことは彼らにメールして確認することができるのだ。 そこで書き落とされた手法がないかを確認する。

そこでいろいろと言われたら一つ一つチェックしていくことになる。 それでも再現できないとなったとき、初めてどうなってんだってことになる。

この追試の過程ってかなりの時間がかかる。 ぱっとやって再現しなかったら諦めちゃう研究者もいるんじゃないかな。 よっぽど結果に興味があるだとか、その方法をどうしても応用したいとかじゃなければね。

研究不正を防ぐには

実験ノートよりもパソコンをなんとかしたい所

よく言われる実験ノート。 数年前の理研での一件の後、大学での実験ノートが厳しくなったとの話を聞いた。

しかしこれは今の時代あまり効かないんじゃないかな。 京大でも実験ノートを使うように指示していたというし。 手書きのだから不正できないっていうのはどうなんだろうかね。 不正するくらいやる気のある人だったら、そこの隠蔽もしっかりするだろう。

また硫酸など試薬をこぼして読めなくなった実験ノートがあったとして、実際その間の取得データ全部廃棄するのかしら。 まあ毎日スキャンをとって保管するようにすれば良いのか。 しかしそれ用の職員を雇うんでもなければ数多い研究者に対してコストが高そう。

やはり今の時代普通はパソコンでデータをまとめるのだから、こちらの透明性を高めるような努力があった方が良いのではないだろうか。

仕事は個人のパソコンの使用を禁止して公的パソコンだけで作業するようにするとか。 ポスドクからは良いけど学生はちょっと大変かな。 でもやっぱり不正はパソコンの中で起こるのだから、パソコンをなんとかするのが一番だよね。

そういった意味では実験装置も変えた方が良いのか。 手書きでデータを取っていくような装置は廃止して、パソコンに自動出力するような装置に変えていく。

生データもしばらく装置本体にも保管されるようにしておけばなお良い。

しかしなんだかギスギスした感じで嫌な感じになるね。 しょうがないのかな。

研究者の待遇改善

これは研究者に限らずだけど。 それなりに努力が報われる社会が良いよね。 努力の方向性が間違っていたとしても。 そういった方向性ってボス次第でどうしようもないこともあるし。

それからドロップアウトに優しい社会の方が、むしろドロップアウトが少なくなるんじゃないかな。 特に頑張って、頑張った上でドロップアウトする人たちには、それなりに良い代替の道が用意されていてほしいもの。

ここでは具体的な話には踏み込まないけど、こういった対策の方が優しい感じがして良い。

アメリカでの印象なんだけど、研究者ってそんなに人気じゃない。 たくさん勉強しなきゃいけないし。 科学は多くいる中国人・インド人を中心としたphdやポスドクに支えられている部分がある。

アメリカ人の優秀所の人たちは生来の科学好きを除けば、もっと給料や待遇の良い道を選んでいるのじゃないか。 ちなみにアメリカの研究者の待遇は悪くなくて、他の仕事の方が努力に対するコストパフォーマンスが良いというだけだけど。

日本だと研究者の人気がないわけではなさそう。 研究職が若い人たちに人気みたいな記事を最近どっかで読んだ。

しかしそういった職業に能力のある人たちに定期的に来てもらうには、それなりの給料や安定した生活を保証する必要がある。 そうでなければ好きでやっている以外の能力ある人たちは別の仕事に行ってしまうよね。 実際理系から文系就職する人ってとても多いし。

アメリカみたいに外人部隊を雇うってのなら良いけれど、日本っていう国はあまり向かないと思うんだ。

研究不正のタイプ別対処

こういう不正の対策に対応するのって、やはりお偉い先生方ってことになるのだろう。

印象先行のところはあるかもしれない。 だがお偉くなっている年代の人たちが自分で研究不正をする場合って金目当てだったり名誉目当てだったりと人生の追加目的って感じがする。 そういった不正に対する対策だったらなんとなくうまいんじゃないかなって。

今回みたいな若手の不正って、先が見えなくて切羽詰まってみたいなところがあるのじゃないか。 そいういのって上の人たちには頭ではわかっても感覚ではわからないんじゃないだろうか。 もちろん状況は理解できるんだろうけど、経験してない人にはそれがどれだけ切実かなんてわからないもんだし。

特に今の30代くらいの人たちって経済が悪化し続けるなかで生きて来た世代。 若い間にどんどん成長する社会を経験してきた人たちとはそもそも精神性からして違いそう。

こういった世代格差って研究分野じゃなくてもよくある。 どちらが悪いってんではなくて違うってだけなんだけど。 自分の常識は自分の成長過程において形成されるものってことで、そんな自分の常識打ち破るのって結構なエネルギーいるよね。

機械的論文審査

またまた脱線してきたので話を戻す。

論文不正は今の時代人に判定させるよりも機械的に判定させた方がよいのでは。 図表やデータにおかしなところがないか読み込ませて判定するようなソフトがあれば良い。 作られたデータに綺麗すぎるなどの特徴があればだけど。 それなりにあるんじゃないかな。

AI研究者の人たちには是非とも頑張って欲しいところ。 そっちで不正が起こってしまったりするかもしれないが。

ソフト自体は別に正確じゃなくても良いんだ。 怪しげだったら追試データを求めるくらいのゆるい審査をすれば良い。 それくらいならみんな嫌がらずに読み込ませるのじゃないか。

研究不正が本当に何か将来に繋がるとも思わないけれど、やったもの勝ちの世界になってしまうのも何か違うよね。

まとめ

*研究不正は技術的に簡単だしバレない可能性も高い

*不正を止めるよりは不正の温床となる原因を取り除こう

*不正審査・不正対策をするなら人的よりも機械的な対策を

[1] 「科学における不正行為」『フリー百科事典 ウィキペディア日本語版』(http://ja.wikipedia.org)。2018年1月23日 (水) 15:04更新版

D